06.03.2025 | Blog Welches LLM ist das richtige? Ein Leitfaden für Unternehmen

1. Größe ist nicht alles: Kleinere Modelle als Alternative

Größere Modelle wie GPT-5.2, Gemini 3.0 oder Claude 4.5 bieten zwar beeindruckende Möglichkeiten, doch sie sind nicht immer nötig. Gerade für Chatbot-Anwendungen in Kombination mit Suchsoftware sind kleinere Modelle oft ausreichend. Denn das entsprechende Wissen, um Fragen zu beantworten, erhält das Modell in diesem Fall von der Suchsoftware. Groß ist also nicht zwingend besser - kleinere Modelle können abhängig vom Use Case vergleichbare Ergebnisse mit hoher Qualität liefern, sind dabei aber schneller und kosteneffizienter.

Möchte man dagegen das externe Wissen eines LLMs mitnutzen, benötigt man große Modelle, mit denen komplexere Anwendungsfälle, wie z.B. Codegenerierung für Entwickler, möglich sind.

2. Sprachunterstützung: Nicht jedes Modell versteht Deutsch

Es gibt beindruckende Vision Language Modelle, die beispielsweise ohne OCR (Optical Character Recognition = optische Zeichen- bzw. Texterkennung) Text aus Bilddateien verarbeiten können. Diese Modelle, aber auch LLMs, sind oft in Sprachen wie Englisch oder Chinesisch trainiert. Wer ein Modell für deutschsprachige Inhalte benötigt, sollte daher prüfen, ob das gewählte LLM ausreichend gut mit deutschen Texten umgehen kann: Erkennt das Vision-Modell beispielsweise Umlaute (ÄÖÜ) oder kann das Text-Modell deutsche Grammatik, Satzbau etc. gut verarbeiten? Auch hier gilt es, das Modell passend zum Anwendungsfall zu evaluieren.

3. Kontextlänge: Wie viel Information kann verarbeitet werden?

Ein weiteres Kriterium bei der Wahl eines Modells ist die Kontextlänge. So sind manche Modelle in der Lage, große Mengen an Informationen auf einmal zu verarbeiten (z.B. Millionen von Token). Hier kommt es ebenfalls auf den Use Case an. Gerade bei der Zusammenfassung langer Dokumente ist beispielsweise eine große Kontextlänge sinnvoll. Für andere Szenarien ist dagegen ein kleineres Modell ausreichend. So werden bei klassischen Suchanfragen die relevanten Inhalte vorab gezielt extrahiert und an das Modell zur Beantwortung weitergegeben, so dass es nicht ganze Dokumente verarbeiten muss. Dies spart nicht nur Rechenleistung, sondern reduziert auch Kosten. Das bedeutet: Ein Modell mit hoher Kontextlänge ist nicht immer die effizienteste Wahl.

4. Open Source vs. Proprietäre Modelle: Welche Lösung passt?

Open Source-Modelle wie gpt-oss, Mistral Magistral/Ministral oder Qwen 3 sind anpassungsfähig, nachvollziehbar und bieten Unternehmen die Möglichkeit, LLMs auf eigener Hardware (On-Premises) zu betreiben und so Datenschutzrisiken zu minimieren. Das sind universelle Modelle mit einem ausgewogenen Mix aus Sprachfähigkeit, Geschwindigkeit und Kosteneffizienz.

Proprietäre Modelle erfordern keine eigene Hardware, da sie in der Cloud betrieben werden. Obwohl die kostenpflichtigen Versionen der Modelle die Nutzerdaten nicht zum Training verwenden, bevorzugen manche Organisationen dennoch On-Prem-Lösungen, um volle Kontrolle über ihre Daten zu behalten.

5. Sicherheit und Kosten: Cloud oder On-Prem?

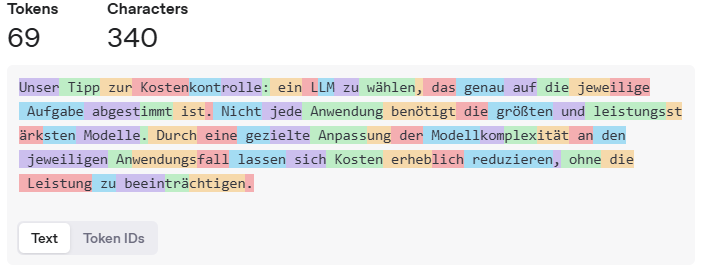

Damit sind wir auch gleich bei der Frage, das Modell selbst auf eigener Hardware zu betreiben oder eine Cloud-Lösung (Software as a Service = SaaS) zu nutzen. Cloud-Modelle wie GPT-4o sind sehr leistungsfähig, erfordern jedoch eine sorgfältige Kostenkontrolle, da die Abrechnung nach Token-Verbrauch erfolgt. Je nach Nutzung kann das teuer werden.

Eine eigene LLM-Infrastruktur anzuschaffen, kann sich für Organisationen lohnen, die langfristig Unabhängigkeit und Datenschutz wahren wollen. Alternativ lassen sich Modelle wie GPT-4o über Microsoft Azure sicher hosten, ohne eigene Hardware anzuschaffen. Die token-basierten Kosten sind auch hier zu berücksichtigen.

Ein Beispiel: So teilt GPT-4o den Text in Token ein. (Quelle: https://platform.openai.com/tokenizer)

6. Exkurs - DeepSeek: Chance oder Risiko?

DeepSeek ist ein Open Source-Modell aus China, das durch seine innovative Architektur und effiziente Rechenleistung zuletzt für Aufsehen gesorgt hat. Es zeigt, dass auch kleinere Modelle mit geringerem Rechenaufwand leistungsfähig sein können. Es ist geeignet zur Lösung komplexer Aufgaben, beschreibt als sogenanntes Reasoning-Modell auch seine „Gedankenschritte“, verbraucht dadurch aber mehr Token. Bei der frei verfügbaren Version gibt es Datenschutzbedenken, da Nutzerdaten für das Training verwendet werden können. Bei einem selbst gehosteten Betrieb wäre die Kontrolle über die Daten gewährleistet. Reasoning-Modelle sind „schlussfolgernde“ KI-Modelle und darauf ausgelegt, logische Denkprozesse nachzuahmen. Sie reflektieren über Aufgabenstellungen, analysieren Probleme schrittweise und liefern logisch begründete Antworten.

Fazit: Lassen Sie sich professionell beraten

Als Anbieter von Enterprise Search-Software mit KI-Assistent verfolgen wir die Entwicklung neuer Modelle mit Spannung. Wir testen diese Modelle, evaluieren neutral ihre Stärken und Schwächen und wissen, was für welchen Use Case und für welche IT-Infrastruktur am besten geeignet. Wir helfen Ihnen, das richtige Modell für Ihren Anwendungsfall zu finden – ob Standardmodell oder „Bring your own model“.

Hintergrundinfo: Token, Kontextfenster und Kosten

Vor allem cloudbasierte LLMs rechnen pro Token ab. Anbieter wie OpenAI (GPT-4o), Google (Gemini) oder Microsoft (Azure OpenAI Service) berechnen die Nutzung ihrer Modelle basierend auf der Anzahl der verarbeiteten Token – sowohl in der Eingabe (Prompt) als auch in der generierten Ausgabe.

Bei lokal betriebenen Open-Source-Modellen entfällt die direkte Token-basierte Abrechnung, aber es entstehen Kosten für Hardware (z. B. GPUs oder Serverkapazitäten), Stromverbrauch und Wartung. Diese Kosten können auf lange Sicht günstiger sein, vor allem wenn die Nutzung hoch ist oder Datenschutz eine zentrale Rolle spielt.

Weiterführende Seiten und Artikel

iAssistant - Schnelle & präzise Antworten

KI-Assistent: die Make or Buy-Entscheidung richtig treffen

Der Autor

Daniel Manzke